摘要:随着计算机网络机房的热密度逐渐增大,空调制冷系统也必须做出相应的改变。本文

介绍了两种针对高热密度机房的空调制冷系统的设计方法,并结合工程实例总结了设计特点及需

要注意的问题等。

当今社会,PC 依然是我们日常工作生活中的核心

工具—我们用PC 处理文档、存储资料,通过电子邮件

或U 盘与他人分享信息。但是如果PC 硬盘发生故障,

我们会因为资料丢失而束手无策甚至造成重大损失。

而在“云计算”时代,“云”会替我们做存储和计算的工

作,可以像使用水或电那样使用IT 基础设施。“云”是

一些可以自我维护和管理的虚拟计算资源,通常为一

些大型服务器集群,包括计算服务器、存储服务器、宽

带资源等。云计算将所有的计算资源集中起来,并由软

件实现自动管理,无需人为参与,,如图1 所示。这使得

应用、提供者无需为繁琐的细节而烦恼,能够更加专注

于自己的业务,有利于创新和降低成本。

通过把新的硬件和软件结合起来实现所谓的云计算式的基础设施,刀片式服务器与虚拟化的结合正在

迅速发展。而高功率密度机架服务器、刀片服务器等高

热密度设备的应用,造成机房的单个机柜功耗不断提

高,单位面积热量急剧上升,因此高热密度的机房一些

问题逐渐涌现出来。

1 现今高密度机房存在的问题

经过大量的实验验证发现,当单个机柜(服务器)

的热负荷接近或超过5kW 时,如果还是采用传统方式

的机房专用空调来解决,就会造成以下问题:

(1)机房环境温度控制得不理想,会有局部“热点”

存在;来自美国的服务器故障统计数据:“在机架顶部

的服务器经常过热;2/3 的故障发生在机架的最顶部的

1/3 处”[1]。

(2)由于设备需要通过大量的循环风来带走如此

多的热量,采用传统的机房空调系统会占用大量的机

房空间。上送风机组需要采用风管的截面积尺寸非常

巨大,下送风机组的架空地板的高度需要提高很多,会

造成很多已经运行的机房将无法继续使用。同时机房

专用机组必须加大送风风机的功率来保证送风风量,

因而造成整个制冷系统的效率大大降低。对于改建工

程的供配电来说也相当棘手。

2 解决方法

目前,专业的数据机房设备供应商及IT 经理最关

心的问题转移到机房的高热密度的处理上来了。因为

如果不能有效地处理机房高热密度,对于机房的容量

扩张以及数据的安全性都是致命性的。为此各大厂商

提出了各种解决方案。

2.1 方案A:直接式机柜精密制冷系统

这种系统主要分两种:1)直接膨胀型,即配置风冷

冷凝器,通过冷媒管连接到机房内,机组直接放置在数

据机柜的旁边或者背部,直接处理机柜散热,需要考虑

外置风冷冷凝器的摆放位置;2)冷水型,配置室外冷

水机组,通过冷水连接,室内机组同样直接放置在数据

机柜的旁边或者背部,或者是一体化的数据机柜,直接

处理机柜散热。

系统特点在于直接对数据机柜进行制冷,适合高

热密度服务器的堆积,减少房间面积和架空地板高度,

可以针对负荷的满载情况调节制冷量,效率较高。

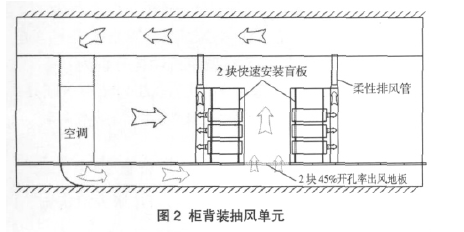

2.2 方案B:水冷机房精密空调柜机+ 柜背装抽风单

元

系统如图2 所示,机房精密空调柜机通过地板送

风系统将处理过的风送入机房内,背式抽风单元与服

务器柜机结合,通过顶部的排风管从数据中心中移出

热空气,避免产生热风短路循环和避免冷、热空气的混

合,热空气通过机房精密空调柜机的回风管系统返回

主机。通过控制抽风风机的转速来处理设备的热量变

化。

这种系统的特点是:1)内置的风机可以变频运行,

根据机组发热量的大小调节风机转速;2) 布置简洁,

装配于机柜背面,占用机房面积小;3)数据机房内无

任何水管道,杜绝水患;4)风扇风量有备用,如发生故

障,剩余风扇可提高风量以维持设计的散热能力;5)

实时监控,通过网络管理了解设备实时发热量,当服务

器发热量较大时,相应排风量较大

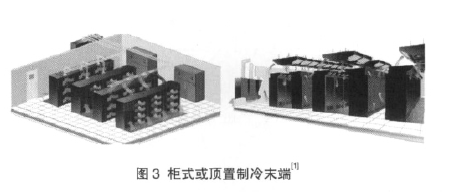

2.3 方案C:水冷机房精密空调柜机+ 柜式或顶置制

冷末端

系统如图3 所示,设备间通过制冷剂管道连接,机

房空调解决空间温湿度,制冷末端解决高热密度局部

及区域制冷。通过制冷剂相变吸收大量机房显热,

100%输出显冷量,既可防止产生冷凝水,又可避免潜

冷量输出而产生的能量损耗,设备末端贴近负载机架,

可大大减少送风所消耗的能量,与传统空调远距离送

风相比,可使风机能耗降低65%,整机节能30%。节能

效果显著。

这种系统的特点是:1)变冷量设计,可以随机房设

备热量变化自动调节制冷量大小,安装灵活,不占用机

房宝贵空间;2)根据机房需求变化增减制冷末端设备;

3)冷媒管布置灵活性高、可扩展性强,便于机房布置变

动或机组升级且无水患的隐患;4) 干盘管技术,100%

显热比,无冷凝水,无除湿损耗。

后两种方式是本文针对本工程实例着重介绍的两

种系统。

3 工程实例

本工程为北京华为科技园区F 楼一层的数据机

房,机房的面积约为855m2(包括机电设备机房和服务

器机房),其中有效的“服务器机房”面积约为612m2。

各类用途的机柜主要由刀片式服务器机柜、小服务器

机柜、NAS 机柜、网络机柜等组成。由于整个园区采用

冷水机组加锅炉的冷热源系统,所以精密空调冷源采

用冷水系统。业主不允许水管进入数据机房内部,所以

方案A 被排除。现就方案B 和方案C 进行比较。

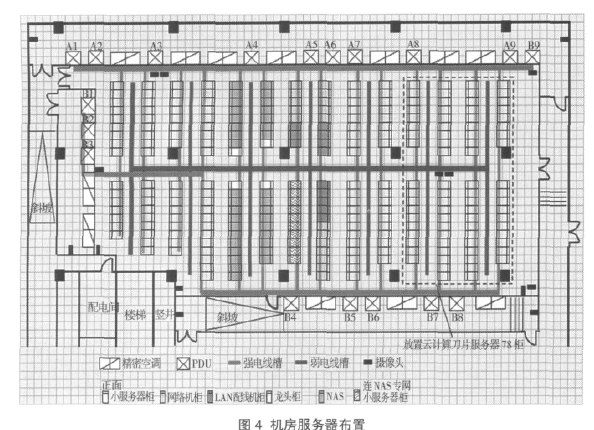

3.1 机房服务器布置

机房服务器布置如图4 所示

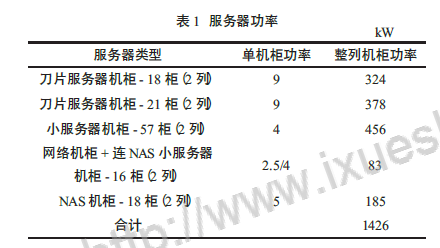

3.2 机房发热量计算

数据机房配电的发热为1426kW,详见表1。围护

结构发热取60W/m2, 总发热为36kW; 照明取为

15W/m2,总照明发热为9kW。故数据机房的总发热功

率约为1471kW。

3.3 设备配置

(1)配置采用“地板下送风精密空调+ 刀片式服务

器机柜气流强排单元”。所有发热量由精密空调处理,

配置精密空调15 台,其中2 台备用,每台148.2kW(显

冷量115.2kW)。设备总冷量满足要求。考虑云计算需

求中“刀片式服务器机柜”数量(78 个),需要配置78

台SX(ARU)机柜气流强排单元;每个机柜气流强排单

元配有4 个无刷直流电机驱动风扇,风扇转速(抽风

量)可以根据总抽气温度进行控制。由于每个刀片式服

务器机柜按照9kW/ 台发热考虑,根据强排单元技术

资料,此时对应的抽风量约为1200m3/h。当刀片机柜内

安装设备(刀片服务器)不满时,如只安装一半,发热量

也只有一半,则对应的抽风量约为600m3/h。刀片式服

务器机柜内部在满配和部分配置时应考虑气流组织问

题,加装适当隔板防止气流短路(机柜前面进入的气流

未经过“刀片服务器电路板”而直接被吸入回风管)。

刀片式服务器机柜前面冷通道地板的开孔率(有

效开孔面积) 应与克服刀片式服务器机柜最大发热量

所需要的最大抽风量相匹配。按照出风风速小于3m/s

计算,至少应有0.12m2 的净出风

面积。

刀片式服务器机柜的“机柜气

流强排单元”的总抽气风量(对应

78 个机柜全部工作在9kW 发热)

应与所选择配置“精密空调(约4

台)”的总风量相匹配(平衡)。

(2)配置采用“地板下送风精

密空调+“一拖多顶置制冷末端”

方式。刀片服务器区域采用一拖多

顶置制冷末端方式,单柜机发热量

的2/3,即6kW 由顶置制冷末端处

理,配置主机5 台,每台制冷量

140kW;每台主机可以带16 台顶

置末端,最多可带80 个顶置空调

末端(实际刀片式服务器柜78

个)。其余设备发热量由精密空调处理,配置精密空调

9 台,其中2 台备用,每台148.2kW(显冷量115.2kW)。

设备总冷量满足要求。

(3)“机柜气流强排单元”每台的最大功耗为

1200W,配置刀片式服务器的正常功耗为820W(与机

柜发热量有关系)。“一拖多”(1 台主机带16 台XDV

末端)系统中,每个制冷末端的功耗为220W。精密空

调主机(115.2kW 显冷量)功耗分两种情况:1)有加湿

加热功能时,最大耗电为20.6kW(风机和加湿都工

作);2)没有加湿加热功能时(如柴油发电机应急电源

供电时,可以禁止加湿加热功能),最大耗电为8.6kW

(只有风机和控制器工作)。“一拖多”主机(140kW 冷

量)的功耗为1.5kW。

对于数据机房的两种空调配置方式,在柴油发电

机应急电源供电情况下,空调主机功耗分别为:

13×8.6kW=111.8kW (全部为精密空调);

9×8.6kW+5×1.5kW=84.9kW(为精密空调和“一

拖多“空调主机)。

两种空调配置方式末端的耗电如下:

78×1.20kW = 93.60kW(78 台刀片服务器采用“背

装强力抽气单元”,由UPS 供电);

78×0.22kW = 17.16kW(78 台刀片服务器采用“机

柜顶装空调末端”,由UPS 供电)。

这些末端都是使用UPS 供电,1a 为365d,1d 为

24h,前者比后者一年至少多耗电约90 万kWh。

(4)新风按每人40m3/h 计算,机房最大工作人员

数按135 人计(业主提供),总新风量为5400m3/h,配置

独立新风机组处理新风,相应排风量为3400m3/h,其余

风量维持室内正压。

(5)本工程实例为改建项目,原来设计的机房发热

量未考虑刀片式服务器的存在,现设备发热量远超当

初的设计容量,预留空调机房面积不足。如果采用方案

B 的话,精密空调机组较多,摆放位置有限,虽然其初投资占优,但是设备运行时耗电量巨大,在用电

费用日

益高涨的今天,显然是不合时宜的。所以经比较研究决

定采用方案C“地板下送风精密空调”+“一拖多顶置

制冷末端”的配置方式。

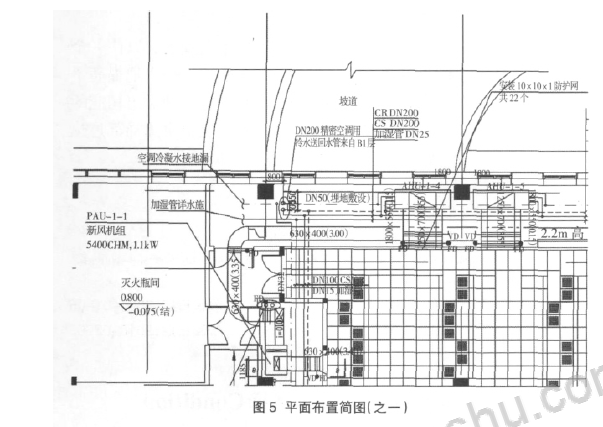

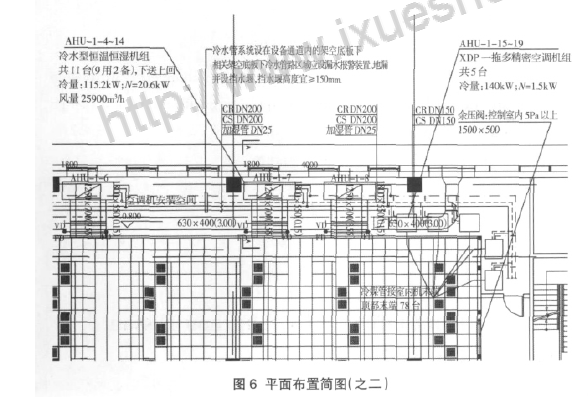

3.4 平面布置简图

平面布置简图如图5 和图6 所示。

3.5 设计注意问题及具体措施

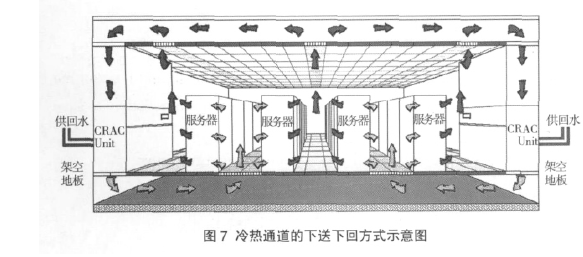

(1)为了更有效组织气流,每两排机

柜应面对面(或背靠背)摆放,间隔形成

冷通道(面对面之间)和热通道(背靠背

之间),如图7 所示[2];每个有源设备机柜

前配置一块通风地板(通风面积应足

够)。每个机柜前、后门带通风网孔,通风

率60%以上。

(2)地板送风管的布置由于送风量

较大,采用风管进入地板空间内部的方

式将导致其它管线的安装困难,以及风

管支架的安装,故采用送风管只安装到

机房出口的方式,不进入数据机房内部

地板空间。尽可能地将精密空调机组面

对热气流通道布置,因为冷气流通道下

气流需要最小的动压,动压小静压大以

保证地板送风口的最大流量。

(3)数据机房内需要新风,要保证室

内正压不小于4.9Pa(与其它房间),与室

外静压差不小于9.8Pa,新风要有过滤措

施。新风量为下列两项中的最大值:1)工

作人员每人40m3/h;2) 维持室内正压所

需风量。

(4)通风地板的开孔率至少需满足

40%要求,集中布置在冷通道之间。满足

出风口风速不大于3m/s 的要求,如果流

速过大将影响冷却效果。

(5)玻璃隔墙可封到顶(天花处),服

务器机房的热风从天花上方回风到空

调,需在机柜“热通道”上方加栅格天花,

精密空调回风处加导风管至隔墙。天花

板吊顶的高度尺寸应保证热气流自然分

层,能有效地被机组回风管吸入。

(6)空调系统宜设初、中效两级空气

过滤器,中效过滤器计数效率应大于

80%,末级过滤器宜设在正压端或送风口部位。

(7)精密空调机组的布置应保证机房内冷量分布

均衡,避免出现局部热点。

(8)精密空调机组至少应为“N+1 模式”运行,设

备应有15%~20%的余量。

(9)在柴油发电机应急供电时,精密空调应能自动

关闭加湿和加热功能,及顺序启动功能,以减少精密空

调集中启动对柴油发电机的冲击和容量要求。

(10)空调系统制冷主机及控制系统(包括电动蝶

阀)需由双路市电供电,并有柴油发电机提供应急备用

电源。

(11)应进行漏水检测。冷水管道要加维修阀门;机

房地板下的地面铺设保温棉,防止下层办公室天花凝

露。

(12)为了确保机房的安全,采用双回路冷水管道,

并在各分支点设置阀门,在服务器机房内冷水管道要

分段设置阀门,便于故障时不停机维修。冷水管道不允

许经过用电设备的上方。

(13)空调机房内的精密空调下方设置15cm 高的

挡水坎,并做防水处理,挡水墙内修建一条低于地面的

排水沟,地面往排水沟倾斜,地漏位于最低处,避免水

渗漏到服务器区域。

4 结语

随着当今计算机网络技术的迅猛发展,以往一个

机房的设备现在被紧凑到一个机架中,极大地提高了

设备的热密度。机房空调制冷系统也必须做出相应的

改进,因此高热密度制冷系统在解决机房内局部过热

方面,成为机房制冷系统的重要组成部分。